近几年,无论是网络安全还是人工智能(AI)都呈现蓬勃发展之态势,并且都上升到了国家战略的高度。从目前来看人工智能和网络安全融合主要有三个方向,分别是人工智能自身安全、人工智能助力安全、人工智能衍生安全。人工智能自身安全,顾名思义就是指AI本身的风险问题,在某些语境下可以简称为“AI安全”,类似于系统安全、网络安全的概念。例如经典的大熊猫对抗样本攻击案例,恶意攻击者只需要修改大熊猫图片上的几个像素点就能导致人工智能系统识别错误,本应该识别出大熊猫却错误地识别成了长臂猿,而且置信度很高。人工智能助力安全即用AI的方法来解决安全的问题。这个领域起步更早,在本世纪初就有科学家基于人工智能技术做垃圾邮件的检测,取得了非常好的效果。近几年在业务安全领域更是涌现出非常有意思的案例,如智能风控、智能反洗钱、智能垃圾内容识别等,这些技术极大地提升了风险识别的准确率和召回率。系统网络安全领域也不例外,衍生出了AISecOps智能安全运营的新理念。人工智能衍生安全是指AI技术导致某些其他领域不安全了,比如最近流行的AI换脸技术,它能够把照片或者视频中的人脸换成另外一个人,而且比Photoshop更加方便,这类技术使得内容安全领域面临前所未有的挑战。

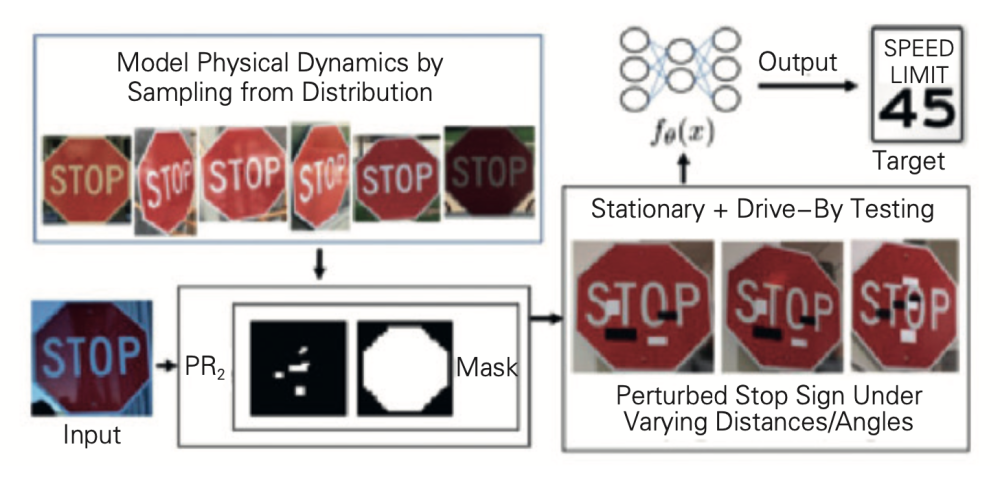

任何一项技术都伴随着安全风险,人工智能技术也不例外,近年来,越来越多的安全专家和人工智能专家揭示了大量AI技术自身的安全问题。安全专家称之为“AI安全”。保障系统安全运行是安全专家的职责,而揭示风险是实施风险控制闭环的关键步骤,于是就出现了各种“花式吊打”AI的方法。下图是一个交通标志的例子,原本应该被AI识别出“Stop”的停止标志,但被加上各种扰动之后,最后AI识别出来的结果却是“限速45”,可以想象,如果这种不安全的算法出现在自动驾驶汽车上会带来多大的灾难。

安全领域有一个著名的CVE(Common Vulnerabilities & Exposures)漏洞数据库,它由非营利性组织MITRE运营。2020年10月,MITRE发起了Github开源项目“advmlthreatmatrix”,该项目旨在系统化地梳理针对AI的威胁矩阵,目前已经有蚂蚁集团、微软、IBM、卡耐基梅隆大学等十几家机构和高校参与。在网络攻击实战中,攻击者常常首先下载一个流行的恶意软件并埋入精心构建的后门,该操作被称为“数据毒化”,然后攻击者将这个被毒化的恶意软件再次上传回平台,并宣称是新的恶意软件样本,而一旦该样本被人用来训练恶意软件识别模型,则该模型也就被植入后门,最终效果是凡是带有特殊信息的恶意软件都不会被该模型识别了,即实现了“逃逸攻击”。

这类问题在人工智能的专业领域里被称之为鲁棒性问题、泛化性问题,AI系统的正确率往往不是100%,即使在某些任务下(如人脸识别)正确率已经超越了人类,但是AI系统太容易出错了,尤其是在“对抗环境”下,有来自黑灰产的恶意攻击。随着无人驾驶、机器翻译等AI技术逐步民用,如果安全性要求不达标,势必会影响AI技术的普及和发展。AI承载系统这一层属于网络系统安全领域范畴,如TensorFlow的各类漏洞。AI数据层和AI模型层则涌现出新型的风险,以下介绍三种典型场景。

数据投毒攻击:指攻击者通过在模型的训练集中加入少量精心构造的毒化数据,使模型在测试阶段无法正常使用(可用性问题),或协助攻击者在没有破坏模型准确率的情况下入侵模型(完整性问题)。毒化攻击可以攻击几乎所有算法,包括计算机视觉域算法、自然语言处理域算法、语音域算法、联邦机器学习、推荐、搜索等。此外还会衍生出后门攻击,以图像分类为例,攻击者通过精心构造带触发器的图像数据集毒化模型,使得模型分类错误,将图片分类到攻击者指定的类别。

对抗样本攻击:指利用对抗样本对模型进行欺骗的恶意行为。对抗样本是指在数据集中通过故意添加细微的干扰所形成的恶意输入样本,在不引起人们注意的情况下,可以轻易导致机器学习模型输出错误预测,例如上文提到的交通标志的错误识别会造成无人驾驶汽车做出错误决策从而引发安全事故。对抗样本的发现严重阻碍了AI技术的广泛应用与发展,尤其是对于安全要求严格的领域。因此,近些年来对抗样本攻防技术吸引了越来越多的目光,成为研究的一大热点,涌现出了大量的学术研究成果。

模型窃取:模型窃取攻击是一类数据窃取攻击,攻击者通过向黑盒模型进行查询获取相应结果,窃取黑盒模型的参数或者对应功能。被窃取的模型往往是拥有者花费大量的金钱和时间构建而成的,对拥有者来说具有巨大的商业价值。模型的信息一旦遭到泄露,攻击者就能逃避付费或者开辟第三方服务,从而获取商业利益,使模型拥有者的权益受到损害。攻击者如果成功窃取模型,就可以进一步部署白盒对抗攻击来欺骗在线模型,这时模型的泄露会大大提高攻击的成功率,造成严重的安全问题。